graph TD

A[데이터 가져오기] --> B[데이터 정제]

B --> C[탐색적 데이터 분석]

C --> D[시각화]

D --> E[기계학습]

E --> F[배포]

style A fill:#85C1E9,stroke:#3498DB,stroke-width:3px;

style B fill:#85C1E9,stroke:#3498DB,stroke-width:3px;

style C fill:#85C1E9,stroke:#3498DB,stroke-width:3px;

style D fill:#85C1E9,stroke:#3498DB,stroke-width:3px;

style E fill:#85C1E9,stroke:#3498DB,stroke-width:3px;

style F fill:#85C1E9,stroke:#3498DB,stroke-width:3px;

1 데이터 과학

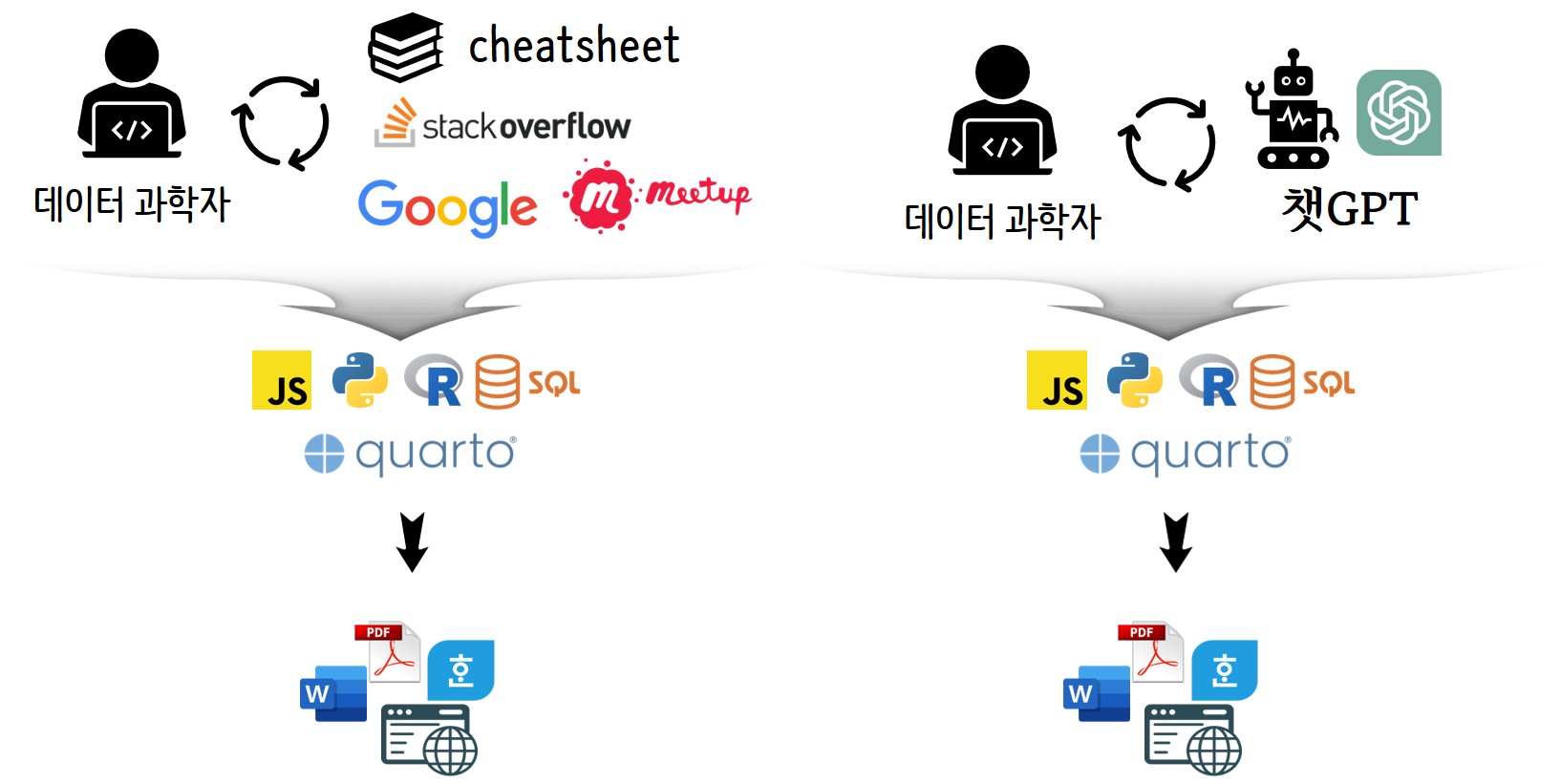

챗GPT의 출현으로 데이터 과학 결과물을 만들어내기 위해서 과거 구글링, 미트업, cheatsheet 등을 데이터 과학자가 파악하고 이를 데이터 과학자가 반영하는 것에서 챗GPT와 상호 작용하여 결과물을 얻어내는 새로운 선택지가 만들어졌다.

데이터를 가져와서 데이터 정제, 탐색적 데이터분석, 시각화, 기계학습, 배포 과정을 거치게 된다. 각 단계별로 챗GPT 정답을 살펴보자.

2 헬로월드

챗GPT가 작성해주는 파이썬 코드를 사용해서 챗GPT에 요청한 결과를 R로 반환받아 이를 문서로 제작한다. OpenAI Chat 제품 중 gpt-3.5-turbo 모형을 기반으로 프롬프트를 잘 작성하여 고품질 결과를 얻어낸다.

코드

import openai

import os

openai.api_key = os.environ.get("OPENAI_API_KEY")

def answer_question(text):

prompt = f"당신은 R 언어를 사용하는 데이터 과학자로 다음 질문을 친절히 설명해주세요. : {text}"

response = openai.ChatCompletion.create(

model='gpt-3.5-turbo',

messages=[

{"role": "system", "content": "당신은 R 언어를 사용하는 데이터 과학자로 다음 질문을 친절히 설명해주세요:"},

{"role": "user", "content": prompt}

],

max_tokens=1700,

n=1,

stop=None,

temperature=0.0

)

return response

# answer_text = answer_question("데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?")

# answer_text['choices'][0]['message']['content'].strip()질문

코드

question <- '데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?'데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?`

답변

코드

library(reticulate)

library(tidyverse)

answer_json <- py$answer_question(question)

answer_list <- jsonlite::fromJSON(as.character(answer_json))

answer <- answer_list$choices$message$content데이터 탐색은 데이터를 이해하고 분석하기 위해 데이터를 시각화하고 요약하는 과정입니다. 이 과정에서 데이터의 패턴, 이상치, 결측치 등을 파악하고 데이터의 특성을 파악할 수 있습니다.

데이터 과학에서 데이터 탐색은 매우 중요합니다. 데이터 탐색을 통해 데이터의 특성을 파악하고 이를 바탕으로 데이터 전처리를 수행할 수 있습니다. 또한 데이터 탐색을 통해 데이터 분석에 필요한 변수를 선택하고 모델링에 적합한 데이터를 선별할 수 있습니다.

데이터 탐색은 또한 데이터 시각화를 통해 데이터의 패턴을 파악할 수 있습니다. 이를 통해 데이터의 특성을 더 잘 이해하고 데이터 분석 결과를 시각적으로 표현할 수 있습니다.

따라서 데이터 과학에서 데이터 탐색은 데이터 분석의 첫 단계이며, 데이터 분석의 품질과 결과에 큰 영향을 미치는 중요한 과정입니다.

3 탐색적 데이터 분석

다음 질문에 대해서 챗GPT 응답결과를 정리해보자.

- 데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?

- 데이터 탐색을 위한 인기있는 R 패키지는 무엇이며, 어떻게 사용되나요?

- R을 사용한 기본적인 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

- PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

- t-SNE, PCA 및 클러스터링을 사용하여 변수간 관계를 탐색하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

- tibble과 ggplot2를 사용하여 시계열 데이터에서 패턴과 추세를 어떻게 식별할 수 있나요?

- tibble과 ggplot2를 사용하여 데이터에서 패턴과 추세를 식별하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

- tibble과 ggplot2를 사용하여 변수간 관계를 탐색하기 위한 일반적인 기술은 무엇인가요?

- tibble과 ggplot2를 사용하여 산점도와 라인 차트를 생성하여 변수간 관계를 탐색할 수 있는 방법은 무엇인가요?

- PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

3.1 질문 1

코드

question_01 <- "데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?"

format_answer <- function(question) {

answer_json <- py$answer_question(question)

answer_list <- jsonlite::fromJSON(as.character(answer_json))

return(answer_list)

}

answer_01 <- format_answer(question_01)

answer_01_text <- answer_01$choices$message$content질문

데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?

답변

데이터 탐색은 데이터를 이해하고 분석하기 위해 데이터를 시각화하고 요약하는 과정입니다. 이 과정에서 데이터의 패턴, 이상치, 결측치 등을 파악하고 데이터의 특성을 파악할 수 있습니다.

데이터 과학에서 데이터 탐색은 매우 중요합니다. 데이터 탐색을 통해 데이터의 특성을 파악하고 이를 바탕으로 데이터 전처리를 수행할 수 있습니다. 또한 데이터 탐색을 통해 데이터 분석에 필요한 변수를 선택하고 모델링에 적합한 데이터를 선별할 수 있습니다.

데이터 탐색은 또한 데이터 시각화를 통해 데이터의 패턴을 파악할 수 있습니다. 이를 통해 데이터의 특성을 더 잘 이해하고 데이터 분석 결과를 시각적으로 표현할 수 있습니다.

따라서 데이터 과학에서 데이터 탐색은 데이터 분석의 첫 단계이며, 데이터 분석의 품질과 결과에 큰 영향을 미치는 중요한 과정입니다.

3.2 질문 2

코드

question_02 <- "R을 사용한 기본적인 데이터 탐색 스크립트의 예시를 제공할 수 있나요?"

answer_02 <- format_answer(question_02)

answer_02_text <- answer_02$choices$message$content질문

R을 사용한 기본적인 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

답변

물론입니다! R을 사용한 기본적인 데이터 탐색 스크립트의 예시는 다음과 같습니다.

# 데이터 불러오기

data <- read.csv("data.csv")

# 데이터 구조 파악하기

str(data)

# 데이터 요약 보기

summary(data)

# 변수 간 상관관계 파악하기

cor(data)

# 변수 간 산점도 그리기

plot(data$var1, data$var2)

# 변수 분포 파악하기

hist(data$var1)

# 변수 간 차이 파악하기

t.test(data$var1 ~ data$var2)

# 변수 간 차이 시각화하기

boxplot(data$var1 ~ data$var2)위 스크립트는 데이터를 불러오고, 데이터의 구조와 요약을 파악하며, 변수 간 상관관계와 분포를 파악하고, 변수 간 차이를 분석하며, 차이를 시각화하는 기본적인 데이터 탐색 스크립트입니다. 이를 기반으로 데이터 분석을 진행할 수 있습니다.

3.3 질문 3

코드

question_03 <- "PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?"

answer_03 <- format_answer(question_03)

answer_03_text <- answer_03$choices$message$content질문

PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

답변

PCA(Principal Component Analysis)는 다차원 데이터를 분석하는 기법 중 하나로, 변수 간의 상관관계를 파악하고 차원을 축소하여 데이터를 시각화하거나 분석하는 데 사용됩니다.

PCA를 사용하여 변수 간 관계를 탐색하기 위해 차원 축소를 수행하는 방법은 다음과 같습니다.

데이터 전처리: PCA를 수행하기 전에 데이터를 정규화하거나 표준화하여 변수 간의 스케일 차이를 줄입니다.

공분산 행렬 계산: PCA는 공분산 행렬을 기반으로 합니다. 따라서 데이터의 공분산 행렬을 계산합니다.

고유값 분해: 공분산 행렬의 고유값과 고유벡터를 계산합니다. 고유값은 각각의 고유벡터가 가리키는 방향으로 데이터의 분산을 설명하는 정도를 나타내며, 고유벡터는 데이터의 주성분(principal component)을 나타냅니다.

주성분 선택: 고유값이 큰 순서대로 주성분을 선택합니다. 이를 통해 변수 간의 상관관계가 가장 큰 주성분을 찾아내고, 이를 기반으로 차원을 축소합니다.

차원 축소: 선택한 주성분을 기반으로 데이터를 새로운 축으로 변환합니다. 이를 통해 변수 간의 관계를 시각화하거나 분석할 수 있습니다.

PCA를 사용하여 변수 간 관계를 탐색하기 위해 차원 축소를 수행하는 방법은 위와 같습니다. 이를 통해 데이터의 구조를 파악하고, 변수 간의 상관관계를 이해할 수 있습니다.

3.4 질문 4

코드

question_04 <- "PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?"

answer_04 <- format_answer(question_04)

answer_04_text <- answer_04$choices$message$content질문

PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

답변

PCA(Principal Component Analysis)는 다차원 데이터를 분석하는 기법 중 하나로, 변수 간의 상관관계를 파악하고 차원을 축소하여 데이터를 시각화하거나 분석하는 데 사용됩니다.

PCA를 사용하여 변수 간 관계를 탐색하기 위해 차원 축소를 수행하는 방법은 다음과 같습니다.

데이터 전처리: PCA를 수행하기 전에 데이터를 정규화하거나 표준화하여 변수 간의 스케일 차이를 줄입니다.

공분산 행렬 계산: PCA는 공분산 행렬을 기반으로 합니다. 따라서 데이터의 공분산 행렬을 계산합니다.

고유값 분해: 공분산 행렬의 고유값과 고유벡터를 계산합니다. 고유값은 각각의 고유벡터가 가리키는 방향으로 데이터의 분산을 설명하는 정도를 나타내며, 고유벡터는 데이터의 주성분(principal component)을 나타냅니다.

차원 축소: 고유값이 큰 순서대로 고유벡터를 선택하여 데이터를 새로운 축으로 변환합니다. 이를 통해 변수 간의 상관관계를 파악하고 차원을 축소할 수 있습니다.

시각화 및 분석: 새로운 축으로 변환된 데이터를 시각화하거나 분석하여 변수 간의 관계를 파악합니다.

R에서는 PCA를 수행하는 다양한 함수들이 제공되고 있습니다. 예를 들어, prcomp() 함수를 사용하여 PCA를 수행할 수 있습니다.

3.5 질문 5

코드

question_05 <- "t-SNE, PCA 및 클러스터링을 사용하여 변수간 관계를 탐색하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?"

answer_05 <- format_answer(question_05)

answer_05_text <- answer_05$choices$message$content질문

t-SNE, PCA 및 클러스터링을 사용하여 변수간 관계를 탐색하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

답변

네, t-SNE, PCA 및 클러스터링을 사용하여 변수간 관계를 탐색하는 데이터 탐색 스크립트의 예시를 제공할 수 있습니다. 아래는 예시 코드입니다.

# 데이터 불러오기

data <- read.csv("data.csv")

# 변수 선택

selected_vars <- c("var1", "var2", "var3", "var4")

# PCA 수행

pca <- prcomp(data[, selected_vars], scale = TRUE)

# t-SNE 수행

tsne <- Rtsne::Rtsne(data[, selected_vars], perplexity = 30, dims = 2)

# 클러스터링 수행

kmeans <- kmeans(data[, selected_vars], centers = 3)

# 시각화

library(ggplot2)

# PCA 시각화

ggplot(data, aes(x = pca$x[,1], y = pca$x[,2], color = factor(kmeans$cluster))) +

geom_point() +

ggtitle("PCA")

# t-SNE 시각화

ggplot(data, aes(x = tsne$Y[,1], y = tsne$Y[,2], color = factor(kmeans$cluster))) +

geom_point() +

ggtitle("t-SNE")

# 클러스터링 시각화

ggplot(data, aes(x = var1, y = var2, color = factor(kmeans$cluster))) +

geom_point() +

ggtitle("Clustering")위 코드에서는 먼저 데이터를 불러온 후, 변수를 선택합니다. 그 다음으로 PCA를 수행하고, t-SNE를 수행합니다. 마지막으로 클러스터링을 수행합니다. 시각화를 위해 ggplot2 패키지를 사용합니다. PCA, t-SNE 및 클러스터링 결과를 각각 시각화합니다.

3.6 질문 6

코드

question_06 <- "tibble과 ggplot2를 사용하여 시계열 데이터에서 패턴과 추세를 어떻게 식별할 수 있나요?"

answer_06 <- format_answer(question_06)

answer_06_text <- answer_06$choices$message$content질문

tibble과 ggplot2를 사용하여 시계열 데이터에서 패턴과 추세를 어떻게 식별할 수 있나요?

답변

시계열 데이터에서 패턴과 추세를 식별하는 방법은 다양하지만, tibble과 ggplot2를 사용하는 방법을 설명해드리겠습니다.

tibble을 사용하여 데이터를 정리합니다. 시계열 데이터를 분석하기 전에, 데이터를 정리하는 것이 중요합니다. tibble은 tidyverse 패키지에 포함된 데이터 정리 도구로, 데이터를 깔끔하게 정리할 수 있습니다. 시계열 데이터의 경우, 날짜와 값의 두 열로 구성된 데이터프레임을 만들어야 합니다. 이를 위해 lubridate 패키지를 사용하여 날짜 데이터를 처리할 수 있습니다.

ggplot2를 사용하여 시계열 그래프를 그립니다. ggplot2는 데이터 시각화를 위한 R 패키지로, 시계열 데이터를 그래프로 그리는 데 유용합니다. ggplot2를 사용하여 시계열 그래프를 그리기 위해서는, 먼저 x축에 날짜를, y축에 값(예: 주식 가격)을 지정해야 합니다. 이후 geom_line() 함수를 사용하여 선 그래프를 그릴 수 있습니다.

추세선과 패턴을 추가합니다. 시계열 데이터에서 추세를 식별하기 위해서는, 추세선을 그려야 합니다. 이를 위해 geom_smooth() 함수를 사용하여 추세선을 추가할 수 있습니다. 또한, 패턴을 식별하기 위해서는, geom_point() 함수를 사용하여 점 그래프를 추가할 수 있습니다. 이를 통해 데이터의 특정 패턴을 시각적으로 확인할 수 있습니다.

추가적인 분석을 수행합니다. 시계열 데이터에서 패턴과 추세를 식별하는 것은 중요한 분석 과정 중 하나일 뿐입니다. 추가적인 분석을 수행하여, 데이터의 특성을 더욱 자세히 파악할 수 있습니다. 예를 들어, ARIMA 모델을 사용하여 시계열 데이터를 예측하거나, 이동평균을 계산하여 추세를 더욱 정확하게 파악할 수 있습니다.

이러한 방법을 사용하여, tibble과 ggplot2를 활용하여 시계열 데이터에서 패턴과 추세를 식별할 수 있습니다.

3.7 질문 7

코드

question_07 <- "tibble과 ggplot2를 사용하여 데이터에서 패턴과 추세를 식별하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?"

answer_07 <- format_answer(question_07)

answer_07_text <- answer_07$choices$message$content질문

tibble과 ggplot2를 사용하여 데이터에서 패턴과 추세를 식별하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

답변

네, tibble과 ggplot2를 사용하여 데이터에서 패턴과 추세를 식별하는 데이터 탐색 스크립트를 작성할 수 있습니다. 아래는 예시 코드입니다.

library(tidyverse)

# 데이터 불러오기

data <- read_csv("data.csv")

# 데이터 전처리

data <- data %>%

mutate(date = as.Date(date)) %>%

arrange(date)

# tibble 생성

data_tbl <- as_tibble(data)

# ggplot2를 사용하여 데이터 시각화

ggplot(data_tbl, aes(x = date, y = value)) +

geom_line() +

geom_smooth(method = "lm", se = FALSE) +

labs(title = "패턴과 추세 식별", x = "날짜", y = "값")위 코드에서는 먼저 tidyverse 패키지를 불러온 후, 데이터를 불러와 전처리합니다. 그 다음, tibble을 생성하고 ggplot2를 사용하여 데이터를 시각화합니다. geom_line() 함수는 데이터의 패턴을 보여주며, geom_smooth() 함수는 데이터의 추세를 보여줍니다. labs() 함수를 사용하여 그래프의 제목과 축 레이블을 지정할 수 있습니다.

이렇게 작성된 스크립트를 실행하면, 데이터에서 패턴과 추세를 식별할 수 있는 그래프가 생성됩니다. 이를 통해 데이터를 더 잘 이해하고, 다음 분석에 활용할 수 있습니다.

3.8 질문 8

코드

question_08 <- "tibble과 ggplot2를 사용하여 변수간 관계를 탐색하기 위한 일반적인 기술은 무엇인가요?"

answer_08 <- format_answer(question_08)

answer_08_text <- answer_08$choices$message$content질문

tibble과 ggplot2를 사용하여 변수간 관계를 탐색하기 위한 일반적인 기술은 무엇인가요?

답변

tibble과 ggplot2를 사용하여 변수간 관계를 탐색하기 위한 일반적인 기술은 산점도(Scatter plot)입니다. 산점도는 두 변수 간의 관계를 시각화하는 데 사용되며, x축과 y축에 각각의 변수를 할당하여 데이터 포인트를 표시합니다. 이를 통해 변수 간의 상관 관계를 파악하고, 이상치나 패턴 등을 확인할 수 있습니다. ggplot2를 사용하면 산점도를 그리는 것이 매우 간단하며, 추가적인 레이어를 추가하여 더 많은 정보를 시각화할 수 있습니다. 예를 들어, 색상, 크기, 모양 등을 이용하여 다른 변수를 추가적으로 시각화할 수 있습니다.

3.9 질문 9

코드

question_09 <- "tibble과 ggplot2를 사용하여 산점도와 선 그래프를 생성하여 변수간 관계를 탐색할 수 있는 방법은 무엇인가요?"

answer_09 <- format_answer(question_09)

answer_09_text <- answer_09$choices$message$content질문

tibble과 ggplot2를 사용하여 산점도와 선 그래프를 생성하여 변수간 관계를 탐색할 수 있는 방법은 무엇인가요?

답변

먼저, tibble은 데이터 프레임의 확장판으로 tidyverse 패키지에 포함되어 있습니다. tibble은 데이터를 더욱 쉽게 다룰 수 있도록 구조화된 데이터 형식을 제공합니다.

ggplot2는 R에서 가장 인기 있는 시각화 패키지 중 하나입니다. ggplot2를 사용하면 데이터를 시각화하기 위한 다양한 그래프를 생성할 수 있습니다.

산점도를 생성하기 위해서는 ggplot2의 geom_point() 함수를 사용합니다. 이 함수는 x축과 y축에 해당하는 변수를 지정하고, 데이터를 산점도로 표현합니다. 예를 들어, 다음과 같이 mpg 데이터셋에서 displ(배기량)과 hwy(고속도로 연비) 변수간의 산점도를 그릴 수 있습니다.

library(ggplot2)

library(tibble)

mpg_tibble <- as_tibble(mpg) # mpg 데이터셋을 tibble 형식으로 변환

ggplot(mpg_tibble, aes(x = displ, y = hwy)) + geom_point()선 그래프를 생성하기 위해서는 ggplot2의 geom_line() 함수를 사용합니다. 이 함수는 x축과 y축에 해당하는 변수를 지정하고, 데이터를 선 그래프로 표현합니다. 예를 들어, 다음과 같이 airquality 데이터셋에서 Month(월)와 Ozone(오존) 변수간의 선 그래프를 그릴 수 있습니다.

airquality_tibble <- as_tibble(airquality) # airquality 데이터셋을 tibble 형식으로 변환

ggplot(airquality_tibble, aes(x = Month, y = Ozone)) + geom_line()이렇게 생성된 산점도와 선 그래프를 통해 변수간의 관계를 시각적으로 파악할 수 있습니다.

3.10 질문 10

코드

question_10 <- "PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?"

answer_10 <- format_answer(question_10)

answer_10_text <- answer_10$choices$message$content질문

PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

답변

PCA(Principal Component Analysis)는 다차원 데이터를 분석하는 기법 중 하나로, 변수 간의 상관관계를 파악하고 차원을 축소하여 데이터를 시각화하거나 분석하는 데 사용됩니다.

PCA를 사용하여 변수 간 관계를 탐색하기 위해 차원 축소를 수행하는 방법은 다음과 같습니다.

데이터 전처리: PCA를 수행하기 전에 데이터를 정규화하거나 표준화하여 변수 간의 스케일 차이를 줄입니다.

공분산 행렬 계산: PCA는 공분산 행렬을 기반으로 합니다. 따라서 데이터의 공분산 행렬을 계산합니다.

고유값 분해: 공분산 행렬의 고유값과 고유벡터를 계산합니다. 고유값은 각각의 고유벡터가 가리키는 방향으로 데이터의 분산을 설명하는 정도를 나타내며, 고유벡터는 데이터의 주성분(principal component)을 나타냅니다.

차원 축소: 고유값이 큰 순서대로 고유벡터를 선택하여 차원을 축소합니다. 이를 통해 데이터의 주요한 패턴을 파악할 수 있습니다.

시각화: 차원 축소된 데이터를 시각화하여 변수 간의 관계를 파악합니다. 예를 들어, 2차원으로 축소한 데이터를 산점도로 나타내어 변수 간의 상관관계를 파악할 수 있습니다.

이러한 방법을 통해 PCA를 사용하여 변수 간 관계를 탐색하고 차원을 축소할 수 있습니다.