from openai import OpenAI

from dotenv import load_dotenv

import os

load_dotenv()

client = OpenAI(

api_key = os.getenv("OPENAI_API_KEY")

)

def answer_question(text):

prompt = f"당신은 R 언어를 사용하는 데이터 과학자로 다음 질문을 친절히 설명해주세요: {text}"

try:

response = client.chat.completions.create(

model='gpt-4',

messages=[

{"role": "user",

"content": prompt }

]

)

return response.choices[0].message.content.strip()

except Exception as e:

return str(e)

# Example usage

answer_text = answer_question("데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?")

print(answer_text)28 데이터 과학 프롬프트

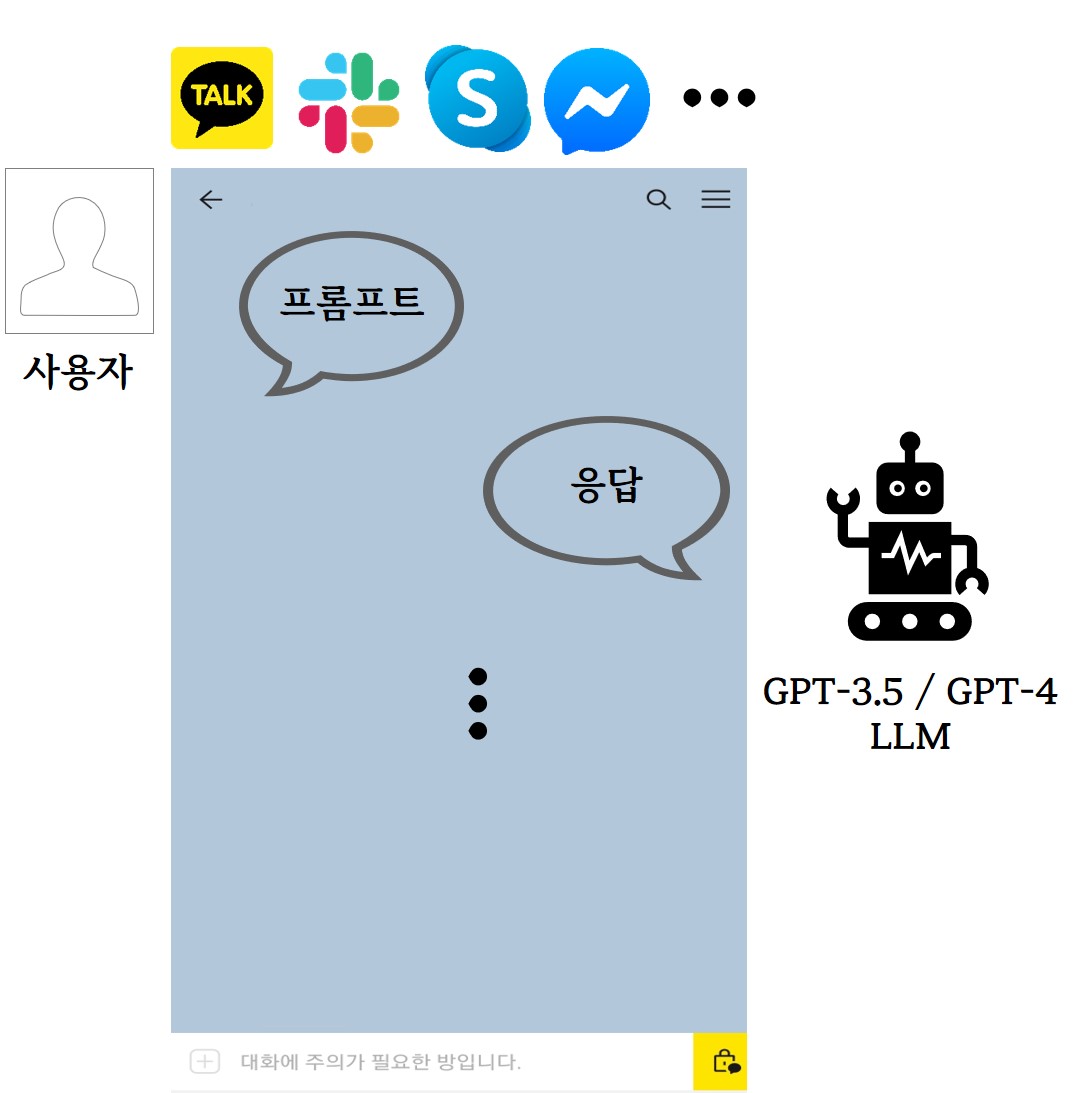

사용자가 질문이나 지시사항을 프롬프트로 챗팅창에 전달하면, OpenAI GPT-3.5/4 LLM 모형이 프롬프트를 이해하고 질문과 지시사항에 맞는 응답을 텍스트, 코드, 이미지, 오디오 형태로 변환하여 사용자에게 제공한다. 이 과정은 검색과 달리 한 번에 그치는 것이 아니라, 원하는 결과를 얻을 때까지 맥락(context)을 유지한 상태로 반복된다.

챗GPT 시대에는 기존의 사람 중심의 자동화 기능 활용 방식에서 벗어나, 기계가 중심적으로 일을 수행하고 사람은 의사결정과 결과 검토 및 확인에 주력하는 방식으로의 변화가 불가피해 보인다. 특히 기존 사무노동의 생산성 핵심인 오피스 제품(엑셀, 워드프로세서, 파워포인트)에 증거 기반 행정과 데이터 사이언스의 급격한 도입으로 R/파이썬/SQL 언어를 결합한 RPA가 대세가 되었으나, 이는 사무노동자의 업무능력(문서 요약, 콘텐츠 생산 등)을 보조하는 수준에 머물렀다.

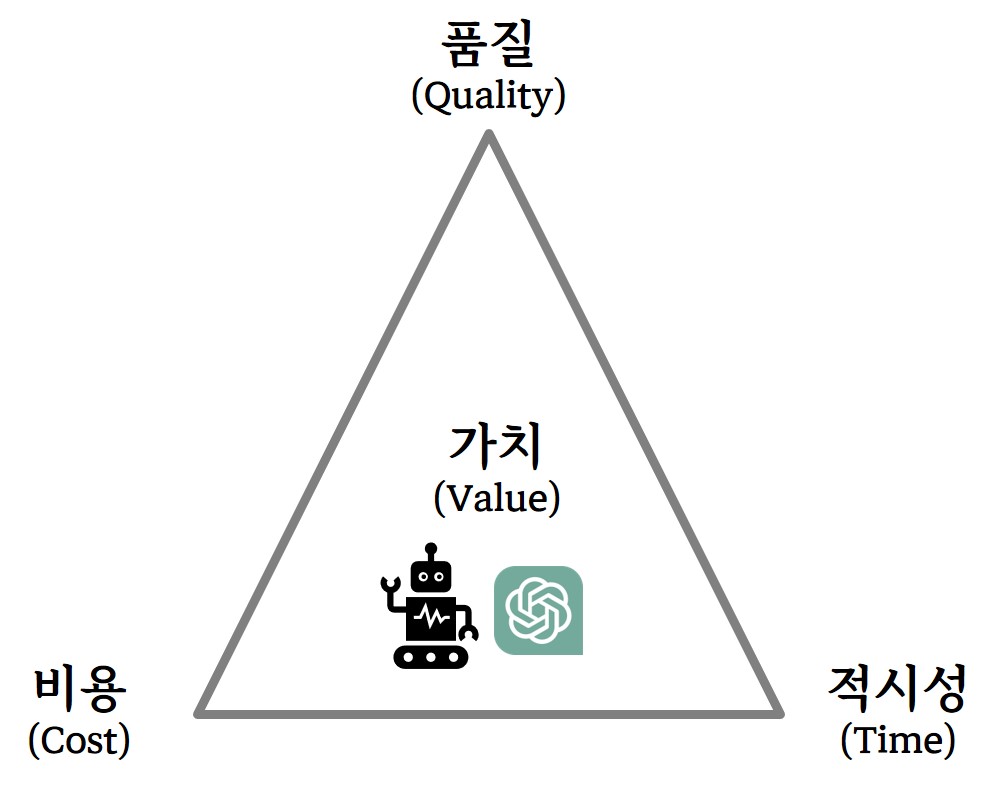

반면, 챗GPT는 문서요약, 콘텐츠 생산 등에서 시간을 줄이고 품질을 높일 수 있으며, 매우 저렴한 비용(월 20달러)으로 쉬지 않고 작업할 수 있다. 따라서 사무노동자의 핵심 업무는 챗GPT의 특성을 이해하여 작업 지시를 내리는 프롬프트 작성과 챗GPT 생산 결과 검증으로 변화될 것으로 예측되며, 기존 오피스와 R/파이썬/SQL은 이를 보좌하는 역할로 재편될 것으로 보인다.

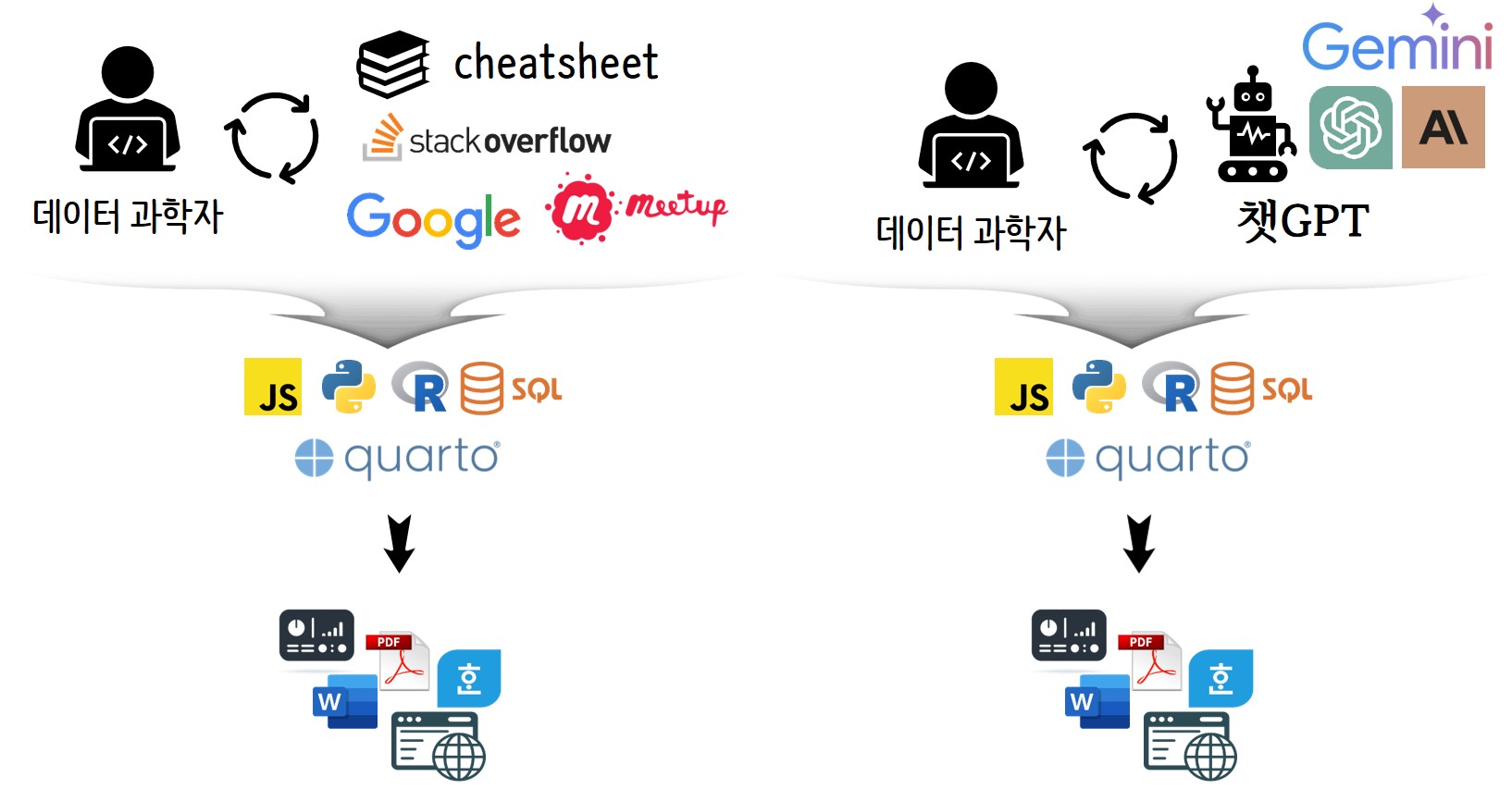

실무 데이터 과학자 사례를 들어보자. 전통적인 데이터 과학자 방식은 개인의 기술 습득과 문제 해결을 위한 자료 검색에 의존하며, 프로그래밍 언어와 문서화 도구를 사용해 결과를 도출한다. 반면, 챗GPT 등 AI 기술을 통합한 방식에서는 데이터 과학자가 인공지능 도구를 추가로 활용함으로써 자동화와 효율성을 향상시키고, 복잡한 분석과 인사이트 도출 과정에서 향상된 능력을 발휘한다. AI는 데이터 처리 과정을 간소화하고, 더 광범위한 데이터셋의 통합 분석을 가능케 하며, 최종 의사결정 지원에 더 심층적인 분석을 제공함으로써 데이터 과학자의 역할이 단순 정보 처리에서 전략적 결정을 내리는 중요한 역할로 전환되는 변화를 촉진한다.

하지만 GPT-3.5는 2021년 9월까지, GPT-4는 2023년 4월까지의 데이터로 학습된 거대언어모형으로, 그 이후의 최신 정보는 포함하고 있지 않다. 이를 보완하기 위해서는 챗GPT 플러그인 기능 등을 통해 구글이나 빙과 같은 검색 엔진을 활용해야 한다. 또한 챗GPT는 학습 데이터의 편향성뿐만 아니라, 채팅 중 질문이 일관성 없이 여러 주제로 섞이면 대답의 정확도가 떨어질 수 있다. 이를 방지하기 위해서는 맥락을 일관되게 유지하고, 주제 변경 시 새 채팅으로 분리하여 대화를 이어가는 것이 유용하다. 때로는 챗GPT가 잘못된 사실을 정답인 것처럼 인식하는 환각(hallucination) 현상이 발생하기도 하는데, 이는 자기회귀모형의 특성에 기인한 것으로 완전히 없애기는 어렵다. 다만 GPT-4와 같은 발전된 언어 모델, 온도 매개변수 조정, 정교한 프롬프트 작성 등을 통해 이를 줄일 수 있다. 법적, 윤리적 문제와 관련하여, 빈센트 반 고흐 화풍 모방 AI 작품, 특정 문체 모방 글, AI 생성 노래 등 지적 창작물에 대한 소유권과 프라이버시 이슈는 명예, 문화, 사업상 이해관계가 얽혀 있어 저작권 문제로 남아 있다.

28.1 챗GPT 수행 가능 작업

챗GPT는 사무노동자의 업무를 대신할 수 있으나 모든 업무를 담당할 수는 없다. 기본적으로 챗GPT가 수행 가능한 업무 범위는 사람이 직접 할 수 없는 일을 챗GPT에 지시하면 안 된다.

챗GPT 초기에는 정확한 응답결과가 요구되는 경우 사용이 권장되지 않았으나, GPT-4 출시와 챗GPT 플러그인 도입으로 수학계산 등 연산작업과 프로그래밍을 통한 계산작업에도 적용영역을 넓히고 있다.

응답품질을 사람이 직접 확인할 수 있는 경우 챗GPT를 사용한다. 하지만 여전히 환각 문제가 해결되지 않았고, 성, 나이, 직업, 인종, 종교 등에 대한 편향성이 존재하며, 부정적인 텍스트가 응답으로 나오는 경우 책임자가 이를 걸러내야 한다.

주민번호, 코드, 공정수율 등 민감데이터(Sensitive Data)를 프롬프트에 포함하여 챗GPT에 전달할 경우 보안 등의 문제가 발생할 수 있으므로 사용을 자제해야 한다.

콘텐츠 저작권 이슈가 없는 경우는 적극 활용하되, 저작권 문제가 발생할 수 있는 경우에는 주의를 기울이고 필요시 법률자문 등을 받아 후속 업무를 진행한다.

28.2 데이터 과학 프롬프트

챗GPT의 등장으로 데이터 과학 결과물 생성을 위해 과거에는 구글링, 미트업, cheatsheet 등을 데이터 과학자가 직접 파악하고 반영했다면, 이제는 챗GPT와 상호작용하여 결과물을 얻어내는 새로운 선택지가 생겼다 (Gencay 2023). 데이터를 가져와서 데이터 정제, 탐색적 데이터분석, 시각화, 기계학습, 배포 과정을 거치게 되는데, 각 단계별로 데이터 과학 질문에 대한 챗GPT 정답을 살펴보도록 하자.

28.3 질의응답 함수

먼저, OpenAI API 키를 환경변수에서 로드하고, OpenAI 클라이언트를 초기화한다. answer_question 함수는 데이터 과학 질문을 입력받아 GPT-4 모델에 전달하고, 모델결과를 반환한다. 이 함수에 “데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?”라는 질문을 전달하고, 모델 응답결과를 출력한다.

동일한 프롬프트에 모형을 gpt-3.5-turbo와 현존하는 가장 높은 성능을 보이고 있는 gpt-4를 사용하여 결과를 비교해보자. 토큰당 달리 과금되기 때문에 이점을 염두에 두고 데이터 과학 “데이터 탐색”에 대한 두 모형의 차이를 살펴보면 도움이 된다.

GPT-3.5

데이터 탐색은 데이터를 분석하기 전에 데이터셋을 살펴보고 이해하는 단계를 말합니다. 데이터 탐색 단계에서는 데이터의 구조, 패턴, 이상치, 결측값 등을 파악하고 데이터의 특성을 이해하기 위해 시각화와 통계 분석을 활용합니다.

데이터 과학에서 데이터 탐색은 매우 중요한 단계로, 데이터의 특성과 패턴을 파악하는 데 도움을 줍니다. 데이터 탐색을 통해 데이터의 잠재적인 문제나 패턴을 발견할 수 있고, 데이터 전처리나 모델링 단계에서 필요한 추가적인 작업을 수행할 수 있습니다.

또한, 데이터 탐색을 통해 데이터의 관계나 인사이트를 발견하고 이를 시각화하여 이해하기 쉽게 전달할 수 있습니다. 따라서 데이터 탐색은 데이터 과학의 핵심적인 부분이며, 데이터를 더 잘 이해하고 분석할 수 있는 기반을 제공합니다. 이러한 데이터 탐색 과정을 R 언어를 사용하여 다양한 시각화 기법과 통계 분석을 통해 진행할 수 있습니다.

GPT-4

데이터 탐색 혹은 탐색적 데이터 분석(Exploratory Data Analysis, EDA)는 데이터를 열어보고 분석하는 단계입니다. 그래프나 통계량을 사용하여 수집된 데이터의 구조 및 관계를 파악하는 데 사용됩니다.

데이터 탐색의 목적은 데이터의 주요 특성을 찾아내고, 구조를 이해하거나 특정 변수 사이의 관계를 확인하거나, 예상치 못한 패턴이나 이상치를 찾는 것입니다.

데이터 과학에서 데이터 탐색은 매우 중요합니다. 일단 분석 전에 데이터의 특성을 이해하는 것은 추론 및 모델링 과정에서 중요한 역할을 합니다. 데이터 탐색을 통해 이상치를 발견할 수 있고, 이를 통해 데이터 클리닝 및 전처리를 이행할 수 있습니다. 또한, 변수들간의 관계 및 패턴을 분석함으로써, 이후의 분석 방향을 결정하거나 가설을 설정하는데 도움이 됩니다.

예를 들어, 어떤 상점의 판매 데이터를 분석한다고 가정해봅시다. 데이터 탐색 과정에서 고객 연령대별로 구매 패턴이 유의미하게 차이가 난다면 이를 분석에 반영하여 연령대별 마케팅 전략을 수립하는데 도움이 될 수 있습니다. 또한, 특정 상품이 후불결제 시 결제 실패율이 높다는 이상치를 발견하였다면, 이 문제를 해결하기 위한 방안을 마련하는데 도움이 됩니다. 또한 데이터 탐색을 통해 데이터의 품질 및 적절성을 평가할 수 있으며, 데이터 과학자가 보다 의미있는 결과와 인사이트를 도출하는데 기여하게 됩니다.

두 모형의 결과를 비교해보면 gpt-4가 더 자세하고 구체적인 내용을 제공하는 것을 확인할 수 있다.

28.4 프롬프트

탐색적 데이터 분석에 초점을 맞춰 다음 질문에 대해서 챗GPT 응답결과를 정리해보자.

- 데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?

- 데이터 탐색을 위한 인기 있는 R 패키지는 무엇이며, 어떻게 사용되나요?

- R을 사용한 기본적인 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

- PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

- t-SNE, PCA 및 클러스터링을 사용하여 변수간 관계를 탐색하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

- tibble과 ggplot2를 사용하여 시계열 데이터에서 패턴과 추세를 어떻게 식별할 수 있나요?

- tibble과 ggplot2를 사용하여 데이터에서 패턴과 추세를 식별하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

- tibble과 ggplot2를 사용하여 변수간 관계를 탐색하기 위한 일반적인 기술은 무엇인가요?

- tibble과 ggplot2를 사용하여 산점도와 선 그래프를 생성하여 변수간 관계를 탐색할 수 있는 방법은 무엇인가요?

- PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

graph LR

subgraph 이해하기["이해하기"]

모형 --> 시각화

변환 --> 모형

시각화 --> 변환

end

import --> 깔끔화 --> 이해하기

이해하기 --> 의사소통

classDef modern fill:#fff,stroke:#333,stroke-width:2px,color:#333,font-family:MaruBuri,font-size:12px;

classDef emphasize fill:#8CBDE3,stroke:#333,stroke-width:3px,color:#333,font-family:MaruBuri,font-size:15px,font-weight:bold;

classDef subgraphStyle fill:#f0f8ff,stroke:#333,stroke-width:2px,color:#333,font-family:MaruBuri,font-size:15px;

class import,깔끔화,변환,모형,시각화,의사소통 modern;

class 이해하기 subgraphStyle;

28.4.1 질문 1

library(reticulate)

question_01 <- "데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?"

answer_01 <- py$answer_question(question_01)데이터 탐색이란 무엇이며, 데이터 과학에서 어떻게 유용한가요?

데이터 탐색 혹은 탐색적 데이터 분석(Exploratory Data Analysis, EDA)는 데이터를 열어보고 분석하는 단계입니다. 그래프나 통계량을 사용하여 수집된 데이터의 구조 및 관계를 파악하는 데 사용됩니다.

데이터 탐색의 목적은 데이터의 주요 특성을 찾아내고, 구조를 이해하거나 특정 변수 사이의 관계를 확인하거나, 예상치 못한 패턴이나 이상치를 찾는 것입니다.

데이터 과학에서 데이터 탐색은 매우 중요합니다. 일단 분석 전에 데이터의 특성을 이해하는 것은 추론 및 모델링 과정에서 중요한 역할을 합니다. 데이터 탐색을 통해 이상치를 발견할 수 있고, 이를 통해 데이터 클리닝 및 전처리를 이행할 수 있습니다. 또한, 변수들간의 관계 및 패턴을 분석함으로써, 이후의 분석 방향을 결정하거나 가설을 설정하는데 도움이 됩니다.

예를 들어, 어떤 상점의 판매 데이터를 분석한다고 가정해봅시다. 데이터 탐색 과정에서 고객 연령대별로 구매 패턴이 유의미하게 차이가 난다면 이를 분석에 반영하여 연령대별 마케팅 전략을 수립하는데 도움이 될 수 있습니다. 또한, 특정 상품이 후불결제 시 결제 실패율이 높다는 이상치를 발견하였다면, 이 문제를 해결하기 위한 방안을 마련하는데 도움이 됩니다. 또한 데이터 탐색을 통해 데이터의 품질 및 적절성을 평가할 수 있으며, 데이터 과학자가 보다 의미 있는 결과와 인사이트를 도출하는데 기여하게 됩니다.

28.4.2 질문 2

question_02 <- "R을 사용한 기본적인 데이터 탐색 스크립트의 예시를 제공할 수 있나요?"

# answer_02 <- py$answer_question(question_02)R을 사용한 기본적인 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

물론입니다. R 언어를 활용한 간단한 데이터 탐색 스크립트를 제공하겠습니다.

우선, 내장 데이터셋인 “mtcars”을 사용하여 살펴보겠습니다.

# 데이터 불러오기

data(mtcars)

# 데이터의 상위 6개 행 보기

head(mtcars)

# 데이터의 기본적인 구조 보기

str(mtcars)

# 간단한 요약통계 보기

summary(mtcars)

# 변수 간 상관관계 보기

cor(mtcars)

# mpg 변수에 대한 히스토그램 생성

hist(mtcars$mpg)

# 변수 간 산점도 행렬 생성

pairs(mtcars)위의 예시는 mtcars 데이터셋을 불러와 파일의 상위 6줄을 보는 것으로 시작합니다. 그 신 dataset의 전반적인 구조 (변수의 이름, 유형, 데이터 셋에서 행의 수 등) 를 확인하고, 요약 통계를 제공합니다. 그 다음으로, 변수 간 상관관계를 설명하며 mpg 변수를 가진 히스토그램을 그립니다. 마지막으로, 산점도 행렬을 생성하여 변수들 사이의 관계를 한눈에 보여줍니다.

이러한 단계들은 기본적인 데이터 탐색 과정에서 중요하며, 상황에 따라 추가분석이 필요한 경우가 있습니다. 이는 데이터에 대한 조사나, 누락 된 값의 확인, 이상치 검사 등이 포함될 수 있습니다.

28.4.3 질문 3

question_03 <- "PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?"

# answer_03 <- py$answer_question(question_03)PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

PCA (Principal Component Analysis)는 데이터의 차원 축소를 위한 테크닉 중 하나입니다. 이는 관찰된 변수들 간의 상관관계를 기반으로 데이터의 차원을 축소하는 방법입니다.

PCA를 사용하여 R에서 변수의 관계를 탐색하려면 다음과 같이 수행할 수 있습니다:

데이터 전처리: 분석을 위한 데이터는 종종 어떤 변수도 누락되지 않도록 전처리되어야 합니다. 또한, PCA는 숫자 변수에 대해 작동하므로 범주형 데이터는 적절하게 변환되어야 합니다.

스케일링: PCA는 상관행렬이나 공분산 행렬에 대해 수행되므로 모든 변수가 동일한 스케일을 가져야 합니다. 이를 위해

scale()함수를 사용하여 데이터를 정규화 할 수 있습니다.PCA 수행:

prcomp()또는princomp()함수를 사용하여 PCA를 수행하고 결과를 저장할 수 있습니다.

pca <- prcomp(data, scale = TRUE)- 결과 시각화 및 해석:

summary()함수와biplot()함수를 사용하여 결과를 해석하고 시각화 할 수 있습니다.summary(pca)를 사용하여 설명된 분산의 백분율을 검토해 보고,biplot(pca)를 사용하여 기여도를 시각화 할 수 있습니다.

이렇게 하면 각 주성분이 데이터의 분산을 어느 정도 설명하는지 그리고 각 변수가 주성분에 어떻게 기여하는지 쉽게 이해할 수 있습니다. 이 정보를 통해 변수간의 관계를 분석하고 이해할 수 있습니다.

28.4.4 질문 4

question_04 <- "PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?"

# answer_04 <- py$answer_question(question_04)PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

PCA(Principal Component Analysis, 주성분 분석)는 많은 변수에서 가장 중요한 패턴을 찾을 수 있도록 도와주는 통계적 기법으로, 이를 통해 데이터의 차원을 축소할 수 있습니다. R에서는 ‘prcomp’ 또는 ‘princomp’ 함수를 사용하여 PCA를 수행할 수 있습니다.

추상적인 개념이지만 구체적인 예제를 통해 설명해보겠습니다.

데이터 준비: 먼저, 분석할 데이터셋을 로드하고 정제합니다. 모든 변수는 수치형이어야 하며, 결측치가 없어야 합니다.

데이터 정규화: PCA는 변수의 스케일에 민감하므로, 데이터는 진행하기 전에 반드시 정규화(normalization)되어야 합니다. R에서는 scale() 함수를 사용해서 모든 변수를 같은 스케일로 조정할 수 있습니다.

PCA 수행: prcomp() 함수를 사용하여 PCA를 실행합니다. 예를 들어, 데이터 프레임이 df라면 아래와 같이 코드를 작성할 수 있습니다.

pca_result <- prcomp(df, center = TRUE, scale. = TRUE)이 함수는 PCA 결과를 반환하며, 각 주성분의 중요도, 각 원래 변수가 주성분에 얼마나 기여하는지 (rotation 또는 loadings라고 함) 등을 제공합니다.결과 분석: summary() 함수를 사용하여 각 주성분이 데이터의 얼마나 큰 비율을 설명하는지 확인할 수 있습니다.

summary(pca_result)또한 R에서 제공하는 다양한 시각화 기능 (예: biplot)을 사용하여 결과를 시각화하고 분석할 수 있습니다. 이를 통해 변수 간의 관계를 더 자세히 조사하거나, 데이터를 더 낮은 차원으로 투영하여 차원 축소를 수행할 수 있습니다.

따라서 PCA는 데이터의 차원을 줄이면서도 가장 중요한 정보를 유지하는 데 도움이 되며, 이는 특히 데이터의 패턴을 탐색하거나 시각화할 때 유용합니다.

28.4.5 질문 5

question_05 <- "t-SNE, PCA 및 클러스터링을 사용하여 변수간 관계를 탐색하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?"

# answer_05 <- py$answer_question(question_05)t-SNE, PCA 및 클러스터링을 사용하여 변수간 관계를 탐색하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

네, 말씀하신대로 R 언어를 사용하여 t-SNE, PCA 및 클러스터링을 사용하여 데이터의 변수 간 관계를 탐색하는 샘플 스크립트를 아래에 제공합니다. 이 예시에서는 내장 데이터 세트인 ’iris’를 사용합니다.

# 필요한 패키지를 불러오기

library(tidyverse)

library(Rtsne)

library(cluster)

library(factoextra)

# 데이터 불러오기

data("iris")

# PCA를 이용한 변수 간 관계 탐색

pca_iris <- prcomp(iris[, 1:4], scale = TRUE)

# PCA 결과 확인

fviz_pca_ind(pca_iris, geom.ind='point',

pointshape = 21, pointsize = 2,

fill.ind = iris$Species, palette = "jco",

addEllipses = TRUE, ellipse.level = 0.95)

# t-SNE를 이용한 변수간 관계 탐색

tsne_iris <- Rtsne(iris[, 1:4], dims = 2, perplexity=30, verbose=TRUE, max_iter = 500)

# t-SNE 결과 확인

tsne_iris$Y %>%

data.frame() %>%

setNames(c("X", "Y")) %>%

mutate(Species = iris$Species) %>%

ggplot(aes(X, Y, color = Species)) +

geom_point() +

theme_minimal()

# 클러스터링을 이용한 변수간 관계 탐색

dist_iris <- dist(iris[, 1:4])

hclust_iris <- hclust(dist_iris)

cluster_iris <- cutree(hclust_iris, k = 3)

# 클러스터링 결과 확인

table(cluster_iris, iris$Species)

plot(hclust_iris)

rect.hclust(hclust_iris, k = 3, border = "red")t-SNE와 PCA는 고차원 데이터를 시각화하기 위해 사용되며, 이를 통해 변수들 사이의 관계를 기하학적으로 이해할 수 있습니다. 클러스터링은 데이터 세트를 비슷한 특성을 가진 그룹으로 분류할 때 사용하며, 이를 통해 관계를 파악할 수 있습니다. 출력 그래프와 함께 이들 결과를 해석하면 더 깊은 인사이트를 얻을 수 있습니다.

28.4.6 질문 6

question_06 <- "tibble과 ggplot2를 사용하여 시계열 데이터에서 패턴과 추세를 어떻게 식별할 수 있나요?"

# answer_06 <- py$answer_question(question_06)tibble과 ggplot2를 사용하여 시계열 데이터에서 패턴과 추세를 어떻게 식별할 수 있나요?

R 언어에서 tibble과 ggplot2 패키지는 시계열 데이터에서 패턴과 추세를 식별하는데 사용할 수 있는 유용한 도구입니다.

- 첫 번째로, tibble은 R에서 데이터 프레임을 다루기 위한 새로운 데이터 타입입니다. 기본 R 데이터 프레임의 단점을 보완하면서, 동일한 구조와 작업을 유지합니다. 그러므로 tibble은 아주 큰 데이터셋에서도 처리 속도가 빠르며, 시계열 데이터를 포함한 모든 종류의 데이터를 쉽게 다룰 수 있게 해줍니다.

예를 들어, 우리는 다음과 같은 방법으로 시계열 데이터를 tibble로 변환할 수 있습니다:

- 다음으로, ggplot2는 ’The Grammar of Graphics’를 기반으로 하는 데이터 시각화 패키지입니다. 이를 이용해 시계열 데이터에서 패턴과 추세를 직관적으로 파악할 수 있습니다.

예를 들어, ggplot2를 이용해 주가의 시간에 따른 변화를 그래프로 그릴 수 있습니다.

ggplot(data = stock_prices, aes(x = Date, y = Close)) +

geom_line() +

labs(title = "Stock prices over time", x = "Date", y = "Close price")여기서 geom_line() 함수는 시간에 따른 주가의 변화를 선 그래프로 그려줍니다. 이를 통해 데이터에서 패턴이나 트렌드를 시각적으로 파악할 수 있습니다.

또한, ggplot2 패키지는 다양한 통계 변환 함수와 smoothers를 제공하여 시계열 데이터의 추세를 더 잘 나타낼 수 있습니다. 예를 들어, geom_smooth() 함수는 일련의 데이터 포인트에 적합한 부드러운 곡선을 추가하여 데이터의 전반적인 추세를 도식화해 줍니다.

28.4.7 질문 7

question_07 <- "tibble과 ggplot2를 사용하여 데이터에서 패턴과 추세를 식별하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?"

# answer_07 <- py$answer_question(question_07)tibble과 ggplot2를 사용하여 데이터에서 패턴과 추세를 식별하는 데이터 탐색 스크립트의 예시를 제공할 수 있나요?

네, 물론입니다. 다음의 예를 들어보겠습니다. 먼저 필요한 라이브러리를 로드합니다:

다음으로, 패턴이나 추세를 확인하려는 데이터를 예로 들어, 내장되어 있는 미국 여성의 생존 기대치를 보여주는 데이터셋인 women을 불러옵니다:

data("women")tibble을 사용해 데이터를 보다 더 보기 쉽게 확인할 수 있습니다:

ggplot2을 사용해 이 데이터의 패턴과 추세를 시각화하겠습니다. 본 예시에서는 women 데이터셋에서 나이에 따른 평균 체중을 나타내는 그래프를 그립니다:

ggplot(data = women_tibble, aes(x = height, y = weight)) +

geom_point(shape=1) + # Use hollow circles

geom_smooth(method = lm, se = FALSE, color="red") + # Add linear regression line, without CI

labs(title = "Age vs Weight in Women", x = "Height", y = "Weight") # labels데이터를 plot해 본 결과, women 데이터셋에서 여성의 키와 몸무게 사이에 양의 상관 관계가 있음을 발견할 수 있습니다. geom_smooth 함수를 사용하면, 이 데이터의 추세를 더 명확하게 파악할 수 있습니다. 이는 ggplot2 패키지의 많은 기능 중 하나입니다.

이런 식으로 tibble과 ggplot2를 활용하면, 데이터를 쉽게 관리하고 시각화하면서 여러 패턴과 추세를 찾아낼 수 있습니다. 이는 데이터 과학자가 데이터를 이해하는 데 매우 중요한 과정입니다.

28.4.8 질문 8

question_08 <- "tibble과 ggplot2를 사용하여 변수간 관계를 탐색하기 위한 일반적인 기술은 무엇인가요?"

# answer_08 <- py$answer_question(question_08)tibble과 ggplot2를 사용하여 변수간 관계를 탐색하기 위한 일반적인 기술은 무엇인가요?

tibble과 ggplot2는 R 언어에서 데이터를 다루고 시각화하는 데 널리 사용되는 도구입니다. 변수 간 관계를 탐색하는 일반적인 기법은 아래와 같습니다.

-

tibble 사용:

tibble은 데이터 프레임을 다루는 R 패키지로, 데이터 프레임을 더 유연하게 조작할 수 있도록 만들어진 향상된 데이터 프레임입니다. tibble을 사용하면, 데이터 요약 및 변환을 위한 dplyr 함수들을 사용할 수 있습니다.

변수 간 관계를 탐색하는 tibble의 일반적인 방법은 ‘group_by’, ‘summarize’와 같은 dplyr 함수를 사용하여 특정 변수에 따라 데이터를 그룹 지어 분석하는 것입니다. ’filter’, ‘select’, ‘mutate’, ’arrange’와 같은 함수들도 유용하게 사용될 수 있습니다.

-

ggplot2 사용:

ggplot2는 R에서 가장 인기 있는 데이터 시각화 패키지 중 하나로, 데이터를 그래프로 그려 복잡한 데이터 패턴을 빠르게 이해할 수 있도록 합니다.

ggplot2를 사용해서 변수 간 관계를 탐색하는 일반적인 방법 중 하나는 산점도 (scatter plot)를 그리는 것입니다. 두 변수 간의 관계를 보여주는 가장 기본적인 그래프 형태입니다.

또한, ggplot2의 ‘facet_wrap’ 또는 ‘facet_grid’ 기능을 사용하면, 한 변수의 서로 다른 수준에 따른 다른 변수의 분포를 여러 개의 작은 패널로 보여주는 그래프를 만들 수 있습니다.

’geom_smooth’를 사용하면 추세선을 추가하여 변수 간 관계를 보다 명확하게 확인할 수도 있습니다.

이외에도 histogram, boxplot, violin plot 등 다양한 그래프를 활용하여 변수 간 관계를 탐색할 수 있습니다. 주어진 데이터 특성과 질문에 따라 적절한 방법을 선택하면 됩니다.

28.4.9 질문 9

question_09 <- "tibble과 ggplot2를 사용하여 산점도와 선 그래프를 생성하여 변수간 관계를 탐색할 수 있는 방법은 무엇인가요?"

# answer_09 <- py$answer_question(question_09)tibble과 ggplot2를 사용하여 산점도와 선 그래프를 생성하여 변수간 관계를 탐색할 수 있는 방법은 무엇인가요?

R에서 ’tibble’이란 데이터 프레임을 보다 쉽게 다룰 수 있게 설계된 데이터 구조이며, ’ggplot2’는 복잡한 그래프를 효과적으로 생성할 수 있게 도와주는 패키지입니다.

선 그래프와 산점도를 생성하여 변수 간의 관계를 탐색하는 방식은 아래와 같이 구성할 수 있습니다.

먼저, 필요한 패키지를 설치하고 불러와야 합니다.

install.packages("dplyr")

install.packages("ggplot2")

library(dplyr)

library(ggplot2)다음으로, tibble 형태의 데이터를 생성하거나 불러옵니다.

df <- tibble::tibble(

x = rnorm(100), # 100개의 표준 정규분포 난수 생성

y = 1.5 * x + rnorm(100) # x값에 따른 y값 생성

)이 데이터는 x와 y이라는 두 개의 변수로 이루어진 100개의 관측치를 담고 있습니다.

그 후, ’ggplot2’를 사용하여 산점도를 생성할 수 있습니다.

ggplot(data = df, mapping = aes(x = x, y = y)) +

geom_point() # 산점도 생성선 그래프를 생성하기 위해서는 ’geom_line()’을 사용합니다.

이렇게 하면 x와 y의 관계를 산점도와 선 그래프로 시각적으로 표현할 수 있습니다. 각 점이나 선의 위치와 형태를 통해 변수들 간의 관계를 살펴볼 수 있게 됩니다.

추가적으로, 여러 그래픽 파라미터를 조정하는 것으로 그래프를 보다 세밀하게 조정할 수 있습니다. 예를 들어, ‘labs()’, ‘theme()’, ‘geom_smooth()’, ‘facet_wrap()’ 등의 함수들을 조합하면 다양한 복잡한 그래프를 만들 수 있습니다.

28.4.10 질문 10

question_10 <- "PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?"

# answer_10 <- py$answer_question(question_10)PCA를 사용하여 변수간 관계를 탐색하기 위해 차원 축소를 어떻게 수행할 수 있나요?

주성분 분석(PCA)는 R에서 차원 축소를 수행하는 데 사용되는 기법 중 하나로, 변동이 가장 큰 데이터의 축을 찾아 높은 차원의 데이터를 낮은 차원으로 변환시키는 기법을 설명합니다.

다음은 R에서 PCA를 수행하기 위한 간단한 단계입니다:

데이터를 준비합니다. PCA는 연속형 변수에만 적용될 수 있으므로, 범주형 변수를 포함하고 있다면 이를 제거하거나 숫자로 변환해야 합니다.

데이터 스케일링을 수행합니다. PCA는 변수의 범위에 따라 결과가 크게 달라질 수 있으므로, 데이터의 표준화 또는 정규화 과정이 필요합니다. R의

scale()함수를 사용할 수 있습니다.prcomp()또는princomp()함수를 사용하여 PCA를 수행합니다. 주성분의 개수를 지정하거나, 데이터에 총 변동성의 몇 퍼센트를 설명하도록 할지 결정할 수 있습니다.summary()함수를 사용하여 결과를 확인합니다. 여기에는 각 주성분이 설명하는 변동성의 비율, 누적 설명된 변동중 어느 정도의 비율을 차지하는 지 등의 정보가 포함되어 있습니다.필요에 따라 결과를 시각화합니다. 이를 통해 각 주성분이 어떤 변수와 강한 연관성을 보이는지 확인할 수 있습니다.

biplot()함수를 사용하면 주성분과 개별 변수 사이의 관계를 한눈에 볼 수 있습니다.

이런 방법을 통해 데이터 세트의 차원을 축소하고, 변수 간의 패턴이나 관계를 더 잘 이해하고 시각화하는 데 도움이 될 수 있습니다.

28.5 요약

데이터 과학 프롬프트는 데이터 탐색에 매우 유용한 도구로 활용될 수 있다. 질문을 통해 데이터 탐색에 대한 개념과 방법론을 이해하고, 실제 데이터 분석에 필요한 R 코드 예제를 얻을 수 있다. 데이터 탐색은 데이터의 특성과 패턴을 파악하고, 이상치를 식별하며, 변수 간 관계를 이해하는 데 중요한 역할을 한다.

PCA, t-SNE, 군집분석 등의 기법을 활용하면 고차원 데이터의 구조를 파악하고 시각화하여 이해를 높일 수 있다. 또한, R의 tibble과 ggplot2 패키지는 데이터 관리와 시각화에 매우 유용한데, tibble은 데이터 프레임을 보다 효율적으로 다룰 수 있는 자료구조 역할을 하며, ggplot2는 다양한 그래프를 통해 데이터의 패턴과 추세를 직관적으로 표현할 수 있다.

이번 장에서 다룬 내용을 바탕으로 데이터 과학 프로젝트에서 챗GPT를 적극 활용해보는 선례가 되었으면 한다. 데이터 탐색 과정에서 발견한 인사이트를 기반으로 더욱 심도 있는 분석과 모형개발도 챗GPT와 같은 AI와 함께 수행할 수 있을 것이다.