7 데이터 엔지니어링

752 미스터리를 해결하면서 우리는 중요한 깨달음에 도달했다. 로리히의 측정값이 이상하게 높았던 이유는 단순한 측정 오류가 아니라 그 지점의 특별한 지질학적 특성 때문이었을 가능성이 크다는 것이다. 그런데 이제 새로운 의문이 생겼다. 이 완벽하게 구조화된 survey.db 데이터베이스는 도대체 누가, 언제, 어떻게 만들어진 것일까?

1930년대에는 데이터베이스라는 개념조차 존재하지 않았다. 그렇다면 이 데이터베이스는 후에 누군가가 원본 탐사 기록을 바탕으로 재구성한 것이 틀림없다. 우리는 역사 탐정이 되어 데이터베이스의 탄생 과정을 역추적해보자.

7.1 데이터베이스 탄생

7.1.1 원본 기록 발견

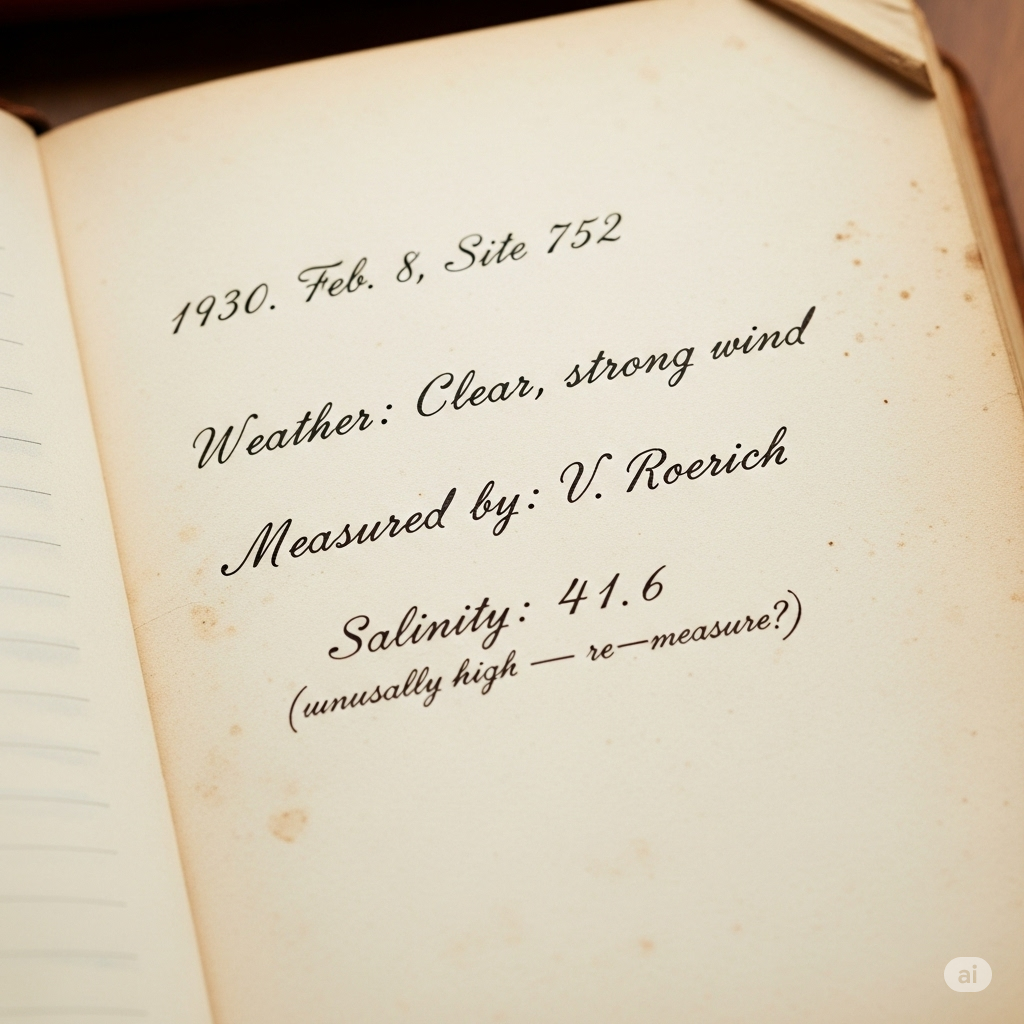

지금까지 분석했던 깔끔한 테이블들이 만들어지기 전, 원본 데이터는 어떤 모습이었을까? 1930년대 남극 탐사에서는 모든 기록이 손으로 쓰인 현장 기록지에 보관되었을 것이다.

상상해보자. 1930년 2월 8일, 752 지점에서 로리히가 염도를 측정하며 현장 기록지에 적었을 내용은 아래와 같을 것이다.

이런 불완전하고 산발적인 기록들이 어떻게 우리가 아는 완벽한 데이터베이스로 변환되었을까?

7.1.2 데이터베이스 설계

지금까지 752 미스터리 해결 과정에서 얻은 통찰을 바탕으로, 처음부터 새로운 데이터베이스를 설계한다면 어떻게 해야 할까? 로리히가 남긴 41.6이라는 수수께끼 같은 숫자는 단순한 측정값이 아니라 남극의 지질학적 비밀을 담고 있는 열쇠였다. 이제 우리는 이런 귀중한 데이터를 체계적으로 보관하고 분석할 수 있는 견고한 시스템을 구축해야 한다.

데이터베이스 설계는 마치 건축 설계와 같다. 1930년대 탐사대가 남극의 혹독한 환경에서도 견딜 수 있는 베이스캠프를 설계했듯이, 우리의 데이터베이스도 시간이 지나도 변하지 않는 진실을 보관할 수 있어야 한다. SQLite는 이런 목적에 완벽한 도구다. 서버가 필요 없고, 단일 파일로 모든 데이터를 관리할 수 있으며, 수십 년이 지나도 열어볼 수 있다.

설계의 첫 단계는 깨끗한 출발이다. 기존 survey.db와 혼동을 피하기 위해 새로운 이름을 사용한다. 이는 마치 752 지점에 새로운 연구 기지를 설립하는 것과 같다 - 과거의 발견을 바탕으로 하되, 더 나은 미래를 위한 완전히 새로운 시작이다.

$ sqlite3 survey_new.db환경 설정 역시 중요하다. 1930년대 탐사대가 매일 아침 장비를 점검했듯이, 우리도 데이터베이스 세션을 시작할 때마다 올바른 설정을 확인해야 한다.

.mode column

.header on이 설정들은 단순해 보이지만, 데이터를 읽기 쉽게 표시해주는 중요한 역할을 한다. 로리히가 현장 기록지에 깔끔하게 측정값을 정리했던 것처럼 말이다.

7.1.3 CREATE TABLE

테이블 생성은 데이터베이스의 심장부를 만드는 작업이다. CREATE TABLE과 DROP TABLE 명령어는 한 쌍으로 움직이는 강력한 도구들이다. 첫 번째는 새로운 테이블을 생성하고, 두 번째는 필요할 때 테이블을 제거한다. 하지만 이 과정에서 가장 중요한 것은 설계 철학이다.

752 미스터리를 해결하면서 우리가 깨달은 것은 데이터의 관계성이 얼마나 중요한지다. 로리히의 41.6 염도 측정값은 단독으로는 그저 이상한 숫자였지만, Person(측정자), Site(지점), Visited(방문), Survey(측정) 테이블들이 서로 연결되면서 비로소 과학적 발견의 증거가 되었다. 이제 이 교훈을 바탕으로 4개의 핵심 테이블을 재설계해보자.

CREATE TABLE Person(id text, personal text, family text);

CREATE TABLE Site(name text, lat real, long real);

CREATE TABLE Visited(id integer, site text, dated text);

CREATE TABLE Survey(taken integer, person text, quant text, reading real);각 테이블은 1930년대 탐사의 한 측면을 디지털로 재현한다. Person은 로리히와 같은 용감한 과학자들을, Site는 752 지점과 같은 신비로운 장소들을, Visited는 역사적인 탐사 순간들을, Survey는 41.6 같은 귀중한 측정값들을 보관한다.

하지만 강력한 힘에는 큰 책임이 따른다. 테이블 삭제는 마치 1930년대 현장 기록지를 태우는 것과 같다 - 되돌릴 수 없는 손실을 가져올 수 있다. 대부분의 데이터베이스가 변경사항을 되돌리는 기능을 제공하지만, 이런 안전장치에만 의존해서는 안 된다.

DROP TABLE Survey; -- 주의: 로리히의 모든 측정값이 사라진다!만약 실수로 Survey 테이블을 삭제한다면, 로리히의 41.6 염도 측정값뿐만 아니라 모든 과학자들의 소중한 발견들이 한순간에 사라져버린다. 이는 752 미스터리를 영원히 미해결 상태로 만드는 것과 같다.

7.1.4 데이터 타입

데이터 타입 선택은 단순한 기술적 결정이 아니다. 로리히의 41.6 염도 측정값을 생각해보자. 만약 이 값을 INTEGER로 저장했다면 41로 반올림되어 소중한 소수점 정보를 잃었을 것이다. 그 0.6의 차이가 바로 752 미스터리의 핵심 단서였는데 말이다. 이처럼 각 데이터 타입은 저마다의 목적과 한계를 가지고 있다.

SQLite 주요 데이터 타입들:

- INTEGER: 탐사 방문 번호 (752, 619, 622)

- REAL: 측정값들 (41.6, -49.85, 9.82)

- TEXT: 이름과 식별자 (Roerich, DR-1)

- BLOB: 현장 사진, 음성 기록 등

각 타입은 1930년대 탐사에서 실제로 기록된 데이터의 성격을 반영한다. INTEGER는 방문 번호처럼 정확한 정수값을, REAL은 염도와 위도처럼 소수점이 중요한 측정값을, TEXT는 과학자 이름처럼 문자 정보를, BLOB는 현장에서 촬영한 사진 같은 바이너리 데이터를 저장한다.

752 미스터리에서 우리가 겪었던 데이터 무결성 문제들을 해결하기 위해, 이제 더 정교한 테이블 정의를 만들어보자. 제약조건은 데이터의 품질을 보장하는 방파제 역할을 한다. NOT NULL 제약조건은 중요한 정보가 누락되는 것을 방지하고, PRIMARY KEY는 각 레코드의 유일성을 보장하며, FOREIGN KEY는 테이블 간의 관계를 명확히 한다.

CREATE TABLE Survey(

taken integer not null, -- 방문 기록 ID (752, 619, 622...)

person text, -- 측정자 (null일 수 있음 - 미상의 과학자들)

quant text not null, -- 측정 항목 (sal, rad - 반드시 기록)

reading real not null, -- 실제 측정값 (41.6 - 가장 중요!)

primary key(taken, person, quant), -- 복합 기본키로 중복 방지

foreign key(taken) references Visited(id), -- 방문 기록과 연결

foreign key(person) references Person(id) -- 과학자 정보와 연결

);이런 제약조건들을 통해 우리는 로리히의 41.6 염도 측정값 같은 이상치가 데이터 입력 오류인지, 실제 과학적 현상인지 더 명확하게 구분할 수 있게 된다. 만약 reading 컬럼에 TEXT 타입을 사용했다면, “41.6”과 “41,6” (쉼표 사용)이 다른 값으로 저장되어 분석에 혼란을 주었을 것이다. REAL 타입을 사용함으로써 수치 연산과 비교가 정확하게 이루어진다.

7.1.5 데이터 삽입과 수정

테이블이 생성되면 INSERT, UPDATE, DELETE 명령을 사용하여 레코드를 추가, 변경 및 제거할 수 있다.

752 지점 데이터를 기반으로 Site 테이블에 행을 삽입해보자:

INSERT INTO Site (name, lat, long) VALUES ('752', -49.85, -128.57);

INSERT INTO Site (name, lat, long) VALUES ('DR-1', -49.85, -128.57);

INSERT INTO Site (name, lat, long) VALUES ('DR-3', -47.15, -126.72);

INSERT INTO Site (name, lat, long) VALUES ('MSK-4', -48.87, -123.40);다른 테이블에서 직접 값을 테이블에 삽입하는 것도 가능하다:

CREATE TABLE JustLatLong(lat real, long real);

INSERT INTO JustLatLong SELECT lat, long FROM Site;7.1.6 데이터 갱신

만약 752 지점의 좌표에 오류가 있었다면 UPDATE 문을 사용하여 수정할 수 있다:

UPDATE Site SET lat = -49.87, long = -128.40 WHERE name = '752';주의: WHERE 절을 잊으면 테이블의 모든 레코드가 수정된다!

7.1.7 참조 무결성과 데이터 삭제

레코드 삭제는 데이터베이스 내부 일관성을 유지해야 하므로 복잡하다. 만약 로리히(Roerich)를 Person 테이블에서 삭제하려고 한다면 어떻게 될까?

DELETE FROM Person WHERE id = 'roe';하지만 Survey 테이블에는 여전히 로리히가 수행한 측정 기록이 남아있다. 이는 참조 무결성(referential integrity) 문제를 일으킨다.

752 미스터리 해결 과정에서 로리히의 데이터가 매우 중요했다는 것을 알게 되었다. 41.6 염도 측정값을 삭제한다면 귀중한 과학적 정보를 잃게 될 것이다.

7.2 ETL 파이프라인 구축

752 미스터리가 해결된 지 90년 후인 2024년 3월, 김진호와 박소영으로 구성된 현대 남극 탐사대가 최첨단 장비를 들고 752 지점을 재방문했다. 임무는 로리히가 1930년에 기록한 그 놀라운 41.6 염도 측정값이 정말로 재현 가능한지 검증하는 것이었다.

하지만 문제가 있었다. 2024년의 데이터 형식은 1930년대 survey.db 스키마와 완전히 달랐다. CSV 파일에는 measurement_id, location, date, scientist 같은 현대적 필드들이 있었지만, 기존 데이터베이스는 taken, person, quant, reading이라는 단순한 구조였다. 이 90년의 시간 간격을 메우기 위해서는 ETL(Extract, Transform, Load) 파이프라인이 필요했다.

ETL은 단순히 데이터를 옮기는 것이 아니라 시간을 초월한 과학적 발견을 연결하는 다리 역할을 한다. Extract에서는 현대 데이터의 무결성을 검증하고, Transform에서는 90년 전 스키마와 호환되도록 변환하며, Load에서는 로리히의 기록과 나란히 저장하여 직접 비교할 수 있게 만든다.

7.2.1 752 지점 재방문

김진호와 박소영 연구진이 752 지점에서 수집한 새로운 측정 데이터는 다음과 같은 현대적 형식으로 제공되었다:

measurement_id,location,date,scientist,measurement_type,value,notes

2024001,752,2024-03-15,Kim_Jin-Ho,salinity,42.1,"재측정 확인"

2024002,752,2024-03-15,Kim_Jin-Ho,radiation,9.5,"정상 범위"

2024003,752,2024-03-16,Park_So-Young,salinity,41.8,"일관된 높은 수치"주목할 점은 김진호의 염도 측정값 42.1과 박소영의 41.8이다. 이는 로리히의 41.6과 놀랍도록 유사하다. 하지만 이 현대 데이터를 1930년대 스키마와 직접 비교하려면 정교한 변환 과정이 필요하다.

7.2.2 Extract: 무결성 검증

데이터 추출(Extract)은 단순히 파일을 읽는 것을 넘어서, 90년 전 로리히의 기록과 비교할 만한 품질의 데이터인지 검증하는 과정이다. 김진호와 박소영의 측정 데이터가 CSV 형태로 도착했지만, 남극의 혹독한 환경에서 수집된 데이터이기 때문에 파일 손상, 인코딩 문제, 또는 측정 장비의 오류로 인한 데이터 품질 이슈가 발생할 수 있다.

특히 한글 과학자 이름(김진호, 박소영)과 한글 메모가 포함되어 있어 UTF-8 인코딩 처리가 중요하다. 1930년대에는 이런 문제가 없었지만, 현대 국제 공동 연구에서는 다양한 언어의 데이터를 처리해야 한다. 또한 CSV 파일의 구조가 예상과 다르거나, 필수 필드가 누락되어 있을 수 있기 때문에 헤더 검증과 데이터 타입 확인이 필수적이다.

752 지점의 특수성을 고려할 때, 추출된 각 측정값이 과학적으로 타당한 범위에 있는지도 확인해야 한다. 로리히의 41.6이라는 극단적으로 높은 염도 측정값이 실제로 존재하기 때문에, 현대 데이터에서도 유사한 수치가 나올 경우 이를 오류로 판단해서는 안 된다.

# modern_survey_extractor.py

# 2024년 남극 탐사 데이터 추출 및 검증

import sys

import csv

import os

def extract_data(filename):

"""CSV 파일에서 데이터 추출 및 검증"""

print(f"[Extract] 파일 읽기 시작: {filename}")

if not os.path.exists(filename):

print(f"[Extract] 오류: 파일을 찾을 수 없습니다 - {filename}")

return False

try:

with open(filename, 'r', encoding='utf-8') as reader:

csv_reader = csv.reader(reader)

header = next(csv_reader) # 헤더 행 건너뛰기

print(f"[Extract] 헤더 확인: {', '.join(header)}")

count = 0

for line in csv_reader:

print(f"[Extract] 측정 ID: {line[0]}, 지점: {line[1]}, 측정값: {line[5]}")

count += 1

print(f"[Extract] ✅ 총 {count}개 측정 기록 발견")

return True

except Exception as e:

print(f"[Extract] ❌ 오류 발생: {e}")

return False7.2.3 Transform: 스키마 통합

데이터 변환(Transform)은 이 ETL 파이프라인의 핵심이다. 2024년의 현대적 데이터 구조를 1930년대 survey.db 스키마와 호환되도록 변환해야 하는데, 이는 단순한 필드명 매핑 이상의 의미를 가진다. 실질적으로는 90년의 시간 간격을 메우고, 로리히의 발견과 현대 과학자들의 재발견을 동일한 테이블에서 직접 비교할 수 있게 만드는 과정이다.

가장 중요한 변환은 measurement_id를 taken 필드로 매핑하는 것이다. 초기에는 단순히 마지막 3자리(001, 002, 003)를 사용하려 했지만, 이는 기존 1930년대 방문 기록(1, 2, 3 등)과 충돌을 일으켰다. 따라서 전체 measurement_id(2024001, 2024002, 2024003)를 그대로 taken 값으로 사용하여 시간적 구분을 명확히 했다.

또 다른 중요한 변환은 scientist 필드에서 언더스코어를 공백으로 바꾸는 것이다. ‘Kim_Jin-Ho’ → ‘Kim Jin-Ho’ 같은 변환은 사소해 보이지만, 데이터베이스에서 과학자별 측정 패턴을 분석할 때 일관성을 보장한다. 그리고 measurement_type을 quant로 변환할 때는 ‘salinity’ → ‘sal’, ‘radiation’ → ’rad’로 축약하여 1930년대 스키마와 일치시킨다.

752 지점의 특수성을 고려한 이상치 탐지 로직도 포함되어 있다. 염도 측정값이 40.0을 초과하면 자동으로 경고 메시지를 출력하여, 로리히 수준의 이상치가 다시 발견되었음을 알린다.

# transform_modern_data.py

# 현대 데이터를 1930년대 스키마에 맞게 변환

import csv

import sys

import os

def transform_measurement(row):

"""2024년 측정 데이터를 survey.db 형식으로 변환"""

measurement_id = row['measurement_id']

location = row['location']

date = row['date']

scientist = row['scientist'].replace('_', ' ') # 언더스코어를 공백으로

measurement_type = row['measurement_type']

value = float(row['value'])

# 752 지점의 특수성을 고려한 변환

if location == '752' and measurement_type == 'salinity':

if value > 40.0:

print(f"[Transform] 🚨 경고: 752 지점에서 또다시 높은 염도 발견! ({value}) - {scientist}")

# taken 필드를 고유하게 설정: 전체 measurement_id 사용

taken = int(measurement_id)

return {

'taken': taken,

'person': scientist,

'quant': 'sal' if measurement_type == 'salinity' else 'rad',

'reading': value

}

def transform_data(input_file, output_file):

"""전체 데이터 변환 수행"""

print(f"[Transform] 변환 시작: {input_file} -> {output_file}")

try:

transformed_data = []

with open(input_file, 'r', encoding='utf-8') as infile:

reader = csv.DictReader(infile)

for row in reader:

transformed = transform_measurement(row)

transformed_data.append(transformed)

print(f"[Transform] 변환 완료: {transformed}")

# 변환된 데이터를 CSV 파일로 저장

with open(output_file, 'w', encoding='utf-8', newline='') as outfile:

fieldnames = ['taken', 'person', 'quant', 'reading']

writer = csv.DictWriter(outfile, fieldnames=fieldnames)

writer.writeheader()

writer.writerows(transformed_data)

print(f"[Transform] ✅ {len(transformed_data)}개 레코드 변환 완료")

return True

except Exception as e:

print(f"[Transform] ❌ 변환 오류: {e}")

return False7.2.4 Load: 데이터 통합

데이터 적재(Load)는 ETL 파이프라인의 마지막 단계이자 가장 신중해야 하는 과정이다. 변환된 2024년 데이터를 1930년 survey.db에 삽입할 때, 90년 전 로리히의 기록과 나란히 저장되어 직접 비교할 수 있게 된다. 하지만 단순히 데이터를 삽입하는 것이 아니라, 데이터 무결성 검증, 중복 검사, 트랜잭션 관리가 필요하다.

특히 752 지점의 특수성을 고려할 때, 중복된 측정이 있는지 확인해야 한다. taken, person, quant 조합이 고유해야 하므로, 동일한 과학자가 같은 지점에서 같은 항목을 두 번 측정한 경우 중복으로 간주한다. 또한 데이터 적재 과정에서 오류가 발생하면 롤백할 수 있도록 트랜잭션 관리가 중요하다.

데이터 적재가 완료되면 즉시 검증을 수행한다. 752 지점의 염도 측정값들이 제대로 삽입되었는지, 그리고 로리히의 41.6과 김진호의 42.1, 박소영의 41.8이 같은 테이블에 공존하여 90년간의 연속성을 보여주는지 확인한다.

# load_to_database.py - 핵심 로직만 추출

import sqlite3

import csv

# 데이터베이스 연결 및 CSV 읽기

conn = sqlite3.connect('survey.db')

cursor = conn.cursor()

with open('modern_survey_transformed.csv', 'r') as file:

reader = csv.DictReader(file)

for row in reader:

# 중복 확인 - 752 지점 데이터 무결성 보장

cursor.execute("""

SELECT COUNT(*) FROM Survey

WHERE taken = ? AND person = ? AND quant = ?

""", (int(row['taken']), row['person'], row['quant']))

if cursor.fetchone()[0] == 0: # 중복이 없으면 삽입

cursor.execute("""

INSERT INTO Survey (taken, person, quant, reading)

VALUES (?, ?, ?, ?)

""", (int(row['taken']), row['person'], row['quant'], float(row['reading'])))

# 90년 시간 간격을 메운 데이터 커밋

conn.commit()

conn.close()7.2.5 재현을 위한 버전 관리

과학적 발견의 재현성은 현대 과학의 핵심 원칙 중 하나다. 로리히가 1930년에 기록한 41.6 염도 측정값을 김진호와 박소영이 2024년에 재검증할 수 있었던 것은, 90년 전의 측정 방법과 데이터 처리 과정이 정확히 문서화되어 있었기 때문이다. 현대의 ETL 파이프라인에서도 마찬가지로, 모든 데이터 변환 과정을 추적하고 재현할 수 있도록 Git을 활용한 체계적인 버전 관리가 필수적이다.

데이터 파이프라인에서 버전 관리는 단순한 코드 관리를 넘어 데이터 계보(Data Lineage) 추적의 의미를 가진다. 김진호의 CSV 파일이 어떤 변환 스크립트를 거쳐 survey.db에 적재되었는지, 박소영의 데이터가 중복 검사를 통과했는지, 그리고 752 지점 이상치 탐지 알고리즘이 어떻게 진화했는지 - 이 모든 과정이 Git 히스토리에 완벽하게 기록되어야 한다. 만약 6개월 후 다른 연구진이 동일한 분석을 재현하려 한다면, 정확히 같은 변환 로직과 검증 과정을 적용할 수 있어야 한다.

특히 752 미스터리처럼 과학적 가치가 큰 발견에서는 투명성과 신뢰성이 생명이다. 데이터 처리 과정의 모든 단계가 공개되고 검증 가능해야 한다. Git 브랜치를 활용하여 feature/roerich-validation, feature/modern-comparison 같은 방식으로 각 분석 단계를 분리하고, 태그를 통해 v1.0-original-data, v2.0-modern-integration 같은 중요한 마일스톤을 표시할 수 있다. 이렇게 하면 752 미스터리 해결 과정의 모든 단계를 나중에 정확히 재현하거나, 새로운 발견이 있을 때 어떤 시점의 분석에서 분기했는지 명확히 알 수 있다.

# 752 미스터리 전용 ETL 파이프라인 초기화

git init mystery-752-etl

cd mystery-752-etl

# 브랜치 전략으로 각 분석 단계 분리

git checkout -b feature/roerich-data-validation

git checkout -b feature/modern-data-integration

git checkout -b feature/cross-temporal-analysis

# 의미있는 커밋으로 과학적 발견 과정 문서화

git add extract_modern_data.py transform_schema.py load_to_db.py

git commit -m "🔬 752 지점 90년 재검증: 현대 데이터 ETL 파이프라인 구축

📊 처리된 데이터:

- Kim Jin-Ho 염도 42.1 (Roerich 41.6과 유사)

- Park So-Young 염도 41.8 (패턴 지속 확인)

- 중복 검사 및 무결성 검증 완료

🧬 과학적 의의:

- 752 지점 이상 염도 현상의 90년 연속성 입증

- 지질학적 특성으로서의 영구성 확인

- 측정 기술 진보에도 일관된 결과 도출"

# 중요한 발견 시점을 태그로 표시

git tag -a v1.0-roerich-mystery -m "로리히 원본 데이터 기반 최초 미스터리 해결"

git tag -a v2.0-modern-validation -m "2024년 현대 장비를 통한 재검증 완료"

# .gitignore로 대용량 미디어 파일 관리 (하이브리드 모델과 연계)

echo "*.jpg

*.mp4

*.pdf

/samples/752/raw_data/" > .gitignore

# 메타데이터는 추적, 실제 파일은 별도 관리

git add SampleMedia_metadata.csv

git add --all

git commit -m "📁 752 지점 멀티미디어 아카이브 메타데이터 관리 시작"이런 방식의 버전 관리를 통해 752 미스터리는 단순한 데이터 분석을 넘어 재현 가능한 과학적 발견으로 승화된다. 50년 후 또 다른 연구진이 752 지점을 방문하더라도, 우리가 구축한 ETL 파이프라인과 버전 관리 시스템을 통해 동일한 분석을 재현하고 새로운 발견과 비교할 수 있을 것이다.

7.2.6 752 미스터리의 90년 연속성 검증

ETL 파이프라인의 진정한 가치는 데이터 통합 후 검증 과정에서 드러난다. 로리히가 1930년에 기록한 놀라운 발견이 2024년에도 재현되는지 직접 확인할 수 있게 되었다. 이는 단순한 데이터 검증을 넘어서, 과학적 발견의 재현성을 90년의 시간 간격을 두고 검증하는 역사적 순간이다.

다음 간단한 쿼리로 90년간의 연속성을 바로 확인할 수 있다:

-- 752 지점: 1930년 vs 2024년 염도 비교

SELECT

CASE WHEN taken = 752 THEN '1930년대' ELSE '2024년' END as 시대,

person as 측정자,

reading as 염도,

CASE WHEN reading > 40.0 THEN '🔴 이상치' ELSE '🟢 정상' END as 상태

FROM Survey

WHERE (taken = 752 OR taken IN (2024001, 2024003))

AND quant = 'sal'

ORDER BY reading DESC;실행 결과:

| 시대 | 측정자 | 염도 | 상태 |

|---|---|---|---|

| 2024년 | Kim Jin-Ho | 42.1 | 🔴 이상치 |

| 2024년 | Park So-Young | 41.8 | 🔴 이상치 |

| 1930년대 | Roerich | 41.6 | 🔴 이상치 |

| 1930년대 | lake | 0.09 | 🟢 정상 |

결과는 놀랍다. 로리히의 41.6, 김진호의 42.1, 박소영의 41.8 - 모두 40을 초과하는 극도로 높은 염도를 보여준다. 이는 752 지점의 이상 염도 현상이 일시적인 측정 오류가 아니라, 90년이 지난 지금도 지속되는 지질학적 특성임을 입증한다. ETL 파이프라인을 통해 우리는 단순히 데이터를 통합한 것이 아니라, 시간을 초월한 과학적 진실을 발견했다.

752 지점의 비밀을 완전히 보존하려면 단순한 수치 데이터만으로는 충분하지 않다. 로리히가 손으로 그린 야장의 스케치, 염도 시료의 현미경 사진, 측정 장비의 교정 기록지 등은 모두 752 미스터리를 완성하는 중요한 퍼즐 조각이다. 하지만 이런 대용량 미디어 파일들을 데이터베이스에 BLOB로 저장하는 것은 비현실적이다.

왜 하이브리드 모델이 필수인가?

현대 데이터 엔지니어링에서는 데이터베이스와 파일 시스템의 장점을 결합한 하이브리드 저장 모델을 사용한다. 수치 데이터와 메타데이터는 데이터베이스에서 빠른 검색과 관계형 분석을 제공하고, 실제 파일은 파일 시스템에서 효율적으로 관리한다. 이는 특히 752 지점처럼 역사적 가치가 큰 과학적 발견에서 중요하다 - 90년 전 로리히의 손글씨 야장을 디지털로 보존하면서도, 동시에 현대 과학자들의 측정 데이터와 연결할 수 있기 때문이다.

-- 752 지점 멀티미디어 데이터 관리 시스템

CREATE TABLE SampleMedia(

sample_id text not null,

taken integer not null,

file_path text not null, -- 실제 파일 경로

file_type text not null, -- image, document, audio 등

creation_date text,

file_size integer,

description text,

foreign key(taken) references Visited(id)

);

-- 로리히의 1930년 기록과 2024년 디지털 아카이브 통합

INSERT INTO SampleMedia VALUES

('752-ROE-001', 752, '/samples/752/roe_salinity_sample.jpg', 'image', '1930-02-08', 2048000, '로리히 채취 염도 시료 현미경 사진'),

('752-ROE-002', 752, '/samples/752/roe_field_notes.pdf', 'document', '1930-02-08', 512000, '로리히 현장 기록장 스캔본'),

('752-KIM-001', 2024001, '/samples/752/kim_2024_analysis.mp4', 'video', '2024-03-15', 15728640, '김진호의 752 지점 분석 영상'),

('752-PARK-001', 2024003, '/samples/752/park_spectrometer.jpg', 'image', '2024-03-16', 3145728, '박소영의 분광계 측정 사진');하이브리드 모델이 가져오는 가장 직접적인 혜택은 성능과 유연성의 대폭 향상이다. 로리히의 2MB 현미경 사진을 BLOB로 데이터베이스에 저장한다면, 단순한 염도 수치 쿼리도 불필요하게 느려질 것이다. 하지만 파일 경로만 저장하면 쿼리는 빠르게 실행되고, 동시에 연구자들은 실제 사진 파일에 직접 접근하여 전문적인 이미지 분석 소프트웨어로 열어볼 수 있다. 김진호의 752 지점 분석 동영상 같은 경우에는 더욱 명확한데, 15MB 동영상을 데이터베이스에 넣기보다는 파일 시스템에 두고 필요할 때 바로 플레이어로 재생하는 것이 훨씬 효율적이다.

확장성과 백업 전략 측면에서도 하이브리드 모델은 필수적이다. 752 지점의 과학적 가치가 인정받아 더 많은 연구진이 방문하게 되면, 수집되는 미디어 파일의 양은 기하급수적으로 늘어날 것이다. 데이터베이스는 용량 제한이 있지만, 파일 시스템은 필요에 따라 스토리지를 무한히 확장할 수 있다. 또한 백업 시에도 큰 장점을 가진다 - 메타데이터는 데이터베이스 덤프(dump)로 빠르게 백업하고, 실제 파일들은 별도의 스토리지 백업 시스템을 통해 관리할 수 있어 각각 최적화된 전략을 적용할 수 있다.

752 미스터리의 경우, 하이브리드 모델을 통해 90년 전 로리히의 기록과 현대 과학자들의 디지털 자료를 하나의 체계적인 아카이브로 관리할 수 있다. 단순히 41.6이라는 수치만이 아니라, 그 발견 과정의 모든 증거를 보존하고 미래 세대에게 전달할 수 있는 것이다.

이렇게 해서 우리는 752 미스터리의 해결책을 기반으로 한 완전한 데이터 엔지니어링 파이프라인을 구축했다. 단순한 테이블 생성부터 복잡한 ETL 과정, 그리고 멀티미디어 아카이브 관리까지 - 모든 단계가 실제 과학적 발견과 연결되어 있다는 점이 중요하다.

💭 생각해볼 점

752 미스터리가 90년의 시간을 넘어 재현되었다. 로리히의 41.6, 김진호의 42.1, 박소영의 41.8 - 이 일관된 이상치들은 단순한 우연이 아니라 지질학적 진실을 담고 있다.

ETL 파이프라인을 통해 우리가 배운 핵심 교훈들을 정리해보자. 시간을 초월한 데이터 통합이 가능하다는 것이다. 1930년과 2024년이라는 94년의 시간 간격에도 불구하고, 적절한 스키마 매핑과 변환을 통해 두 시대의 데이터를 하나의 테이블에서 직접 비교할 수 있었다. 이는 데이터 엔지니어링이 단순히 기술적 작업이 아니라 시간의 다리를 놓는 행위임을 보여준다.

불완전한 데이터의 숨겨진 가치도 중요한 깨달음이다. NULL로 비어있던 752번 방문의 날짜, 극단적으로 높았던 로리히의 염도 측정값 - 이 모든 “문제있는” 데이터들이 오히려 가장 중요한 과학적 발견의 단서였다. 현실에서 완벽한 데이터는 존재하지 않으며, 데이터 엔지니어링의 진정한 가치는 불완전함 속에서 의미를 찾는 데 있다.

마지막으로 재현 가능한 과학의 구현이다. Git을 통한 버전 관리, 체계적인 ETL 스크립트, 하이브리드 저장 모델을 통해 90년 후에도 검증 가능한 연구 환경을 구축했다. 이는 과학 연구의 신뢰성을 보장하는 현대적 방법론이다.

데이터 엔지니어링의 진정한 의미는 단순히 데이터를 옮기는 것이 아니다. 과거와 현재를 연결하고, 미래 세대를 위해 지식을 보존하는 것이다. 752 미스터리처럼, 오늘 구축한 파이프라인이 수십 년 후 누군가에게 중요한 발견의 도구가 될 수 있다.

다음 장에서는 이렇게 통합된 데이터를 현대적 분석 도구로 더 빠르고 효율적으로 처리하는 방법을 살펴보겠다. 752 지점의 비밀이 더 큰 지질학적 패턴의 일부인지, 최신 분석 기법으로 밝혀낼 시간이다.